クローラーの権限を監査し、AIのデータスクレイピングを無料で管理できます。

時代において ジェネレーティブAI robots.txtファイルはサーバー上で最も重要なセキュリティ文書です。ゲートキーパーがGooglebotに「ようこそ」と伝え、GPTBot(OpenAI)やCCBot(Common Crawl)にあなたの独自コンテンツを取り込んでモデルを訓練する許可があるかどうかを伝えます。

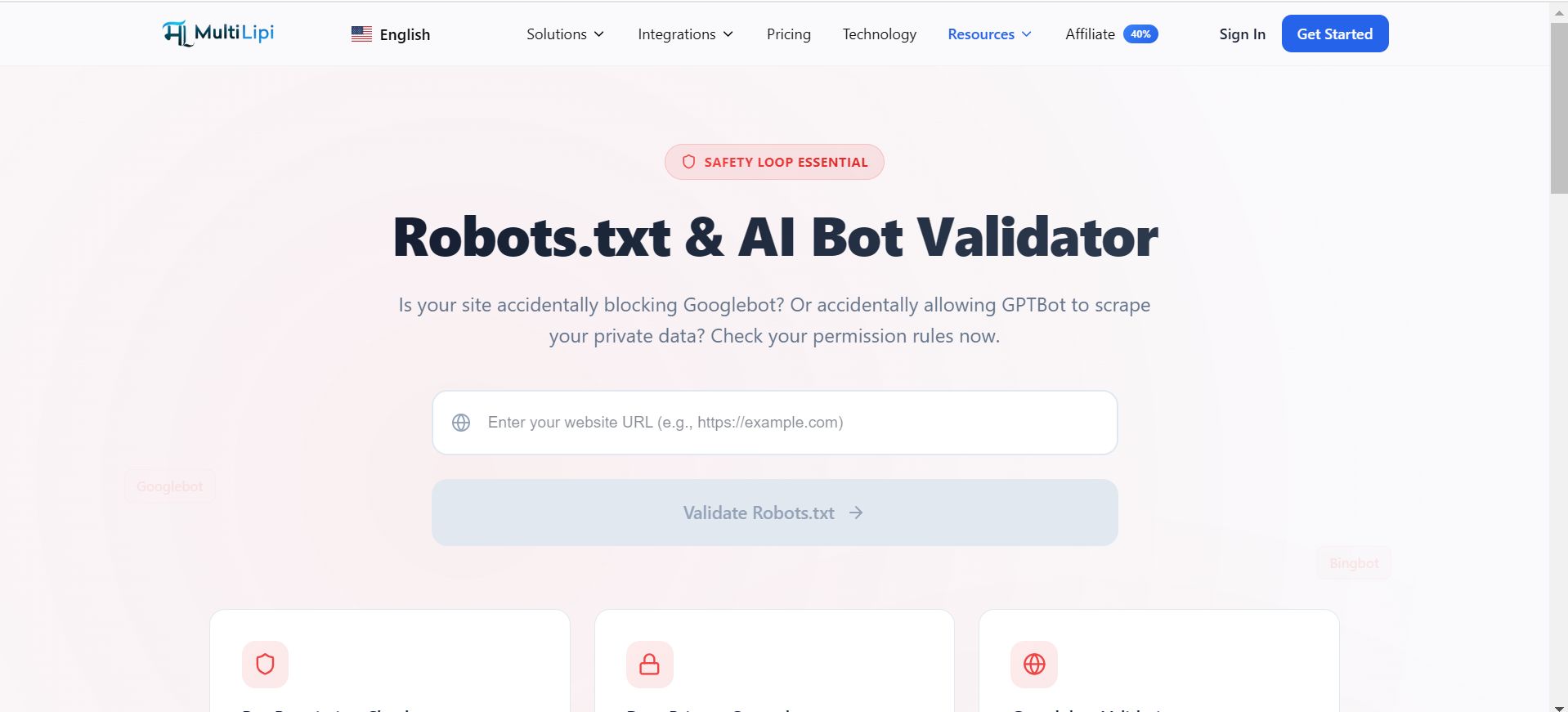

MultiLipi Robots.txt Validatorは、あなたの許可ルールを監査するために設計された無料のエンジニアリングユーティリティです。AIスクレイピングエージェントに対する立場を検証しながら、誤ってSEOトラフィックをブロックしないようにします。

「セーフティループ」の本質

SEOの可視性とAIのプライバシーの違い。

このファイルの構文エラーが一つでも、Googleからウェブサイト全体のインデックス解除される可能性があります。逆に、ルールが欠けているとAI企業が報酬なしであなたのブログアーカイブ全体をスクレーピングしてしまうこともあります。

SEOリスク

GooglebotやBingbotをブロックすると、トラフィックが完全に破壊されます。

AIリスク

GPTBotやClaudeBotを許可すると、あなたのコンテンツはトレーニングデータになります。

バランス

当社のツールは、「許可」および「禁止」指令が構文的に正しく、管理予定の特定のエージェントを対象にしていることを検証します。

監査プロトコル

ゲートキーパーの検証方法。

自分の権限が正しいとは思わないでください。ライブクローラーの基準と照らして検証してください。

無料ツールへのアクセス

Robots.txt検証器に移動しましょう。

入力エンドポイント

ルートドメイン(例:https://example.com)を入力してください。

スキャン実行

「Robots.txtの検証」ボタンをクリックしてください。

レビュー・ロジック

構文チェック、ボット固有の分析、到達可能性を検討してください。

レビューロジック:

構文チェック: フラグ、無効なワイルドカード、パスエラー

ボット固有の分析: 特にGooglebot、GPTBot、Bingbot、CCBotなどの主要エージェントの権限をチェックします

到達のしやすさ: ファイルがアクセス可能であることを確認し、200のOKステータスコードを返すこと

知識グラフの制御

誰があなたから学ぶかを決めてください。

プレミアムパブリッシャーやSaaSプラットフォームであれば、検索エンジンを稼働させつつ、汎用的なAIスクレイパーをブロックしたいかもしれません。

シナリオ

Google検索結果に表示したいけれど、ChatGPTに無料で有料の記事を暗記されたくはないでしょう。

解決

検証者を使って、あなたのことを確実にしてください。 ユーザーエージェント:GPTBot 禁止: / ルールは正しく実装されており、あなたの ユーザーエージェント: * ルール。

多言語サイトマップ

インフラをつなぐこと。

robots.txtはクローラーのマップルームでもあります。XMLサイトマップに明示的にリンクされるはずです。

ザ・チェック

私たちのツールは サイトマップ:https://yoursite.com/sitemap.xml 指令は存在します。

世界的な影響

これは、ローカライズされたサブディレクトリ(例: /fr/ , /es/ ).クローラーがrobots.txtでサイトマップを見つけられなければ、深層翻訳されたページが発見されないままになる可能性があります。